10分の1の法則(13) & グローバル化と英語(10) 合併号

本ブログで取り上げたいテーマ「世界標準と言語」の話をする前に、ちょっとだけインターネットの歴史を見てみましょう。

インターネット・プロトコル(TCP/IP)台頭の前夜

OSIの熱が冷めた後、市場は一挙にインターネットへと行ったかと言うと、そうはなりませんでした。

インターネット・プロトコル自体も、OSIと並んで有力な共通プロトコルの候補でしたが、大きな問題を抱えていました。

インターネット・プロトコルのルーツ

インターネット・プロトコルのルーツは冷戦にありました。

冷戦には様々な定義がありますが、冷戦時代の最大の問題, あるいは冷戦の象徴といえば、何と言っても、核戦争の危機が揚げられます。

安全保障は当然として、多くの国際間の問題も、この核戦争危機を中心に回っていました。

これは通信の世界も例外ではなく、インターネット・プロトコルの誕生にも冷戦が大きく関わっています。

すなわち、軍は核戦争を前提とした技術、すなわち核攻撃にも耐えられるネットワーク を必要としていました。

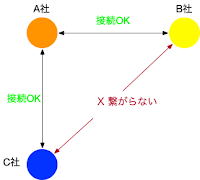

つまり、核攻撃で回線や施設が破壊されても、生き残った回線経路(ルート)を探し、複数の経路が残っている場合にはその中で最適なルートを決定し再接続する作業を自動的に行なえる通信プロトコルが要求され、そして生まれたのがインターネット・プロトコル(の前身)でした。(下図参照)

|

| (図)回線切断と経路の自動設定 |

たいへん便利な通信プロトコルであり、中継ノード(図中の通信制御装置)自体に経路(ルート)を探査し、最新の情報を互いに交換し合って共有する機能が備わっており、回線や中継ノードの破壊や能力低下に備えて常に最適な経路を維持管理する機能を持っています。

中継ノード、通信制御装置が、こう言った機能、役割を持つことから、ルーターと呼ばれるようになったのは、皆さんご存知のことだと思います。

ではこの便利なインターネット・プロトコルで、いったい何が問題だったかというと、その経済性の低さでした。

常に最適な経路を維持管理すると言うことは、逆に言うと、常にネットワーク全体の経路情報を各ノード間で交換し合って常に最新の情報を共有しなければならないことを意味します。

また、全ての経路を常に最速のルートで結ぶと言うのは、ネットワーク全体の資源効率を悪化させることがあります。(必ずしも全ての経路が、最速である必要はないことに注意。現代インターネット技術のポリシー・ルーティング参照)

当時は、通信コストが非常に高額だったため、基幹経路を除けば、ほとんどの通信路は電話回線であり、モデムの処理速度はたかだか14,4kbps〜19.2Kbps程度でした。

そう言う細い(低速の)通信回線の中に、ユーザー・データだけでなく大量のネットワーク管理情報が流れるわけであり、プロトコル・アナライザーなどで測定してみると、コントロール・データ(管理用データ)の比率が50%を超えてしまう事も珍しくありませんでした。

と言うわけで、WAN分野では、軍用や研究用を除き、商業分野では、インターネット・プロトコルなどの動的ルーティングを使うことは稀で、大部分は静的ルーティングを採用し、経路情報やパフォーマンス・チューニング用パラメータを事前に設定するプロトコルを使っていました。

そして、OSIの次に来たのは、プロトコルを共通させるのではなく、マルチ・プロトコル、すなわち、複数種類のプロトコルをまとめて一本の物理回線を共有させて運ぶテクノロジーの時代でした。

ネットワーク・ベンチャーの時代

OSI以前からネットワーク・ベンチャーは存在していましたが、主にLAN分野で活躍していました。

しかし、群雄割拠するプロプライアタリなプロトコル群を、一本の物理回線にまとめて運ぶマルチ・プロトコル・ルーターの登場とともに、データ通信分野の主役は、従来のメインフレーム・メーカーからネットワーク・ベンチャーへと、あっと言う間に様変わりしました。

この当時、1990年前後の代表的なプロトコルは、データ量的には、1. パソコン系プロトコル(マイクロソフトやアップルなど), 2.インターネット系(UNIX系)の順で、メインフレーム系のプロトコルは極めて少数派になっていました。

1990年は、IBMが当時アメリカ史上最大の赤字を計上した年でしたが(注; 後に、その最大赤字の記録は破られます)、メインフレーム系のプロトコルは重要度はまだまだ高かったのですが、データ量的には新興勢力に圧倒され始めていました。